Nvidia ha appena presentato il DGX GH200, un supercomputer di nuova generazione per addestrare l’intelligenza artificiale. Con i nuovi chip Grace Hopper, otterrai la potenza di calcolo di un exaflop.

Sarai anche interessato

[EN VIDÉO] Intervista: come è nata l’intelligenza artificiale? L’intelligenza artificiale mira a imitare il funzionamento del cervello umano, o almeno la sua logica…

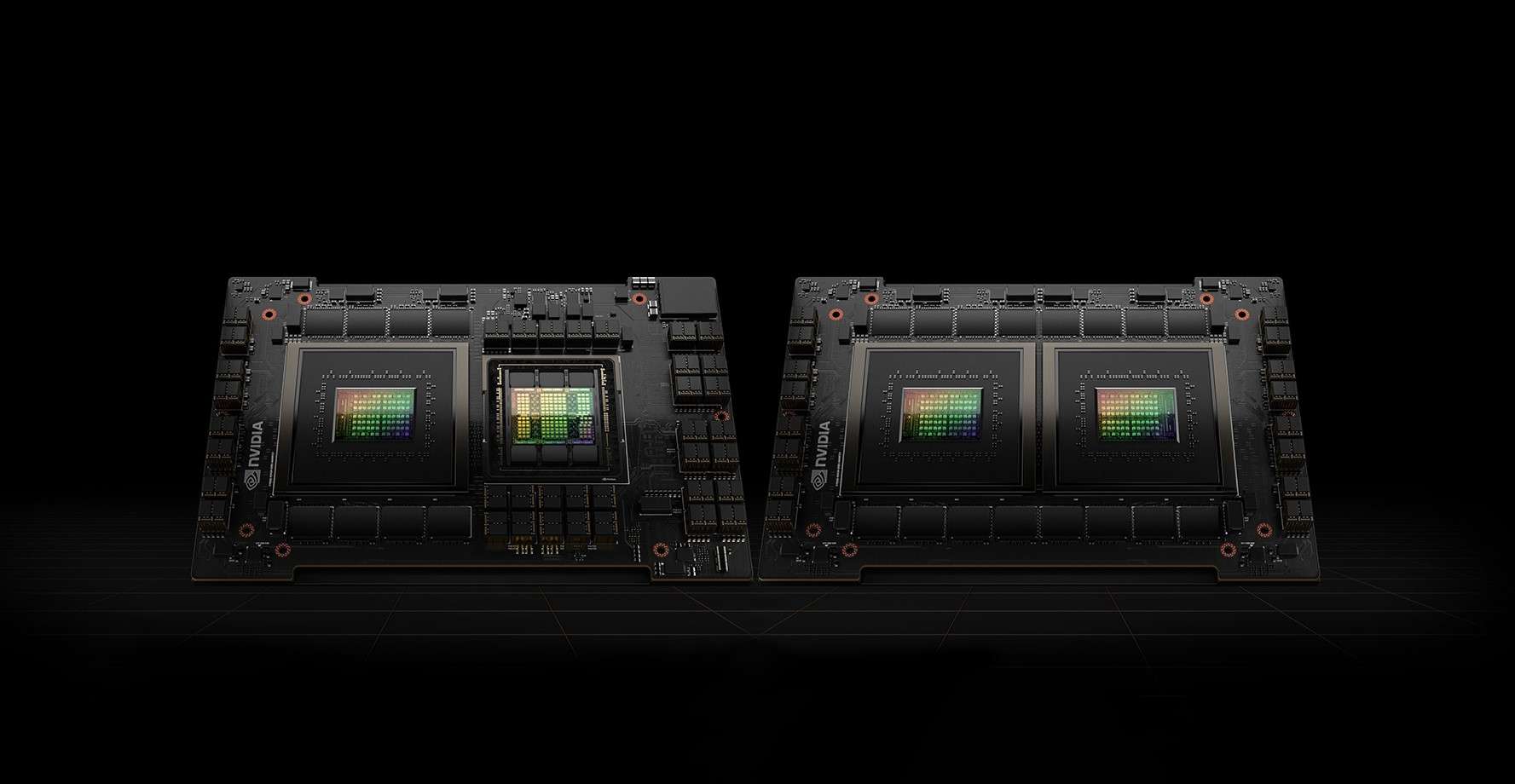

Dopo Intel della scorsa settimana, tocca a Nvidia annunciare nuovi chip e un nuovo supercomputer dedicato all’intelligenza artificiale. Al Computex di questa settimana a Taiwan, il produttore ha presentato il DGX GH200, un supercomputer progettato per addestrare modelli di linguaggio di grandi dimensioni (LLM) che costituiscono la base dell’intelligenza artificiale generativa come ChatGPT.

Il sistema consisterà in un “Grace Hopper” 256 GH200 con 144 TB di memoria condivisa, o 500 volte la memoria del suo predecessore, l’A100. Per un funzionamento ottimale, Nvidia ha combinato il processore Grace e il processore grafico Hopper H100 Tensor Core in un unico chip per creare il nuovo “superchip” GH200. In tutto, il supercomputer DGX GH200 ha una potenza di calcolo, o la metà di quella del supercomputer Intel Aurora, in uscita quest’anno.

Il supercomputer sarà disponibile quest’anno

I vari elementi di questo chip sono interconnessi grazie a Nvidia NVLink-C2C, che moltiplica per sette la larghezza di banda e divide per cinque il consumo energetico rispetto a una connessione PCI Express. Inoltre, tutti i processori grafici del supercomputer potranno lavorare insieme come un unico elemento, il che ne semplifica la programmazione, a differenza della generazione precedente che poteva combinare i processori grafici solo in gruppi di otto.

Nvidia prevede di rilasciare il supercomputer DGX GH200 entro la fine dell’anno. Il produttore ha indicato che Google Cloud, Meta e Microsoft dovrebbero essere tra i primi clienti.

“Pluripremiato studioso di zombi. Professionista di musica. Esperto di cibo. Piantagrane”.